OpenAI再放大招,还是免费的

OpenAI最新发布的GPT-4o模型是迈向更自然的人机交互的一步,232毫秒可响应音频输入。

既不是GPT-5.也不是传闻中的搜索引擎,这次OpenAI于北京时间5月14日凌晨在春季更新活动上带来了GPT-4o,声称该模型可以对语音、图像和文本进行实时推理和交互。用OpenAI联合创始人兼CEO萨姆·奥尔特曼的话来说“就像魔法一样”。

GPT-4o在视觉和音频理解方面表现得较为突出。OpenAI官方介绍称,GPT-4o中的“o”指代“omni”,而“omni”在英语词缀中指代“总、全部、所有”,意为“全能”的意思。GPT-4o是迈向更自然的人机交互的一步——它可以将文本、音频和图像的任意组合作为输入和输出,并在短至232毫秒(平均320毫秒)的时间内对音频输入做出反应,与人类对话的响应时间类似。

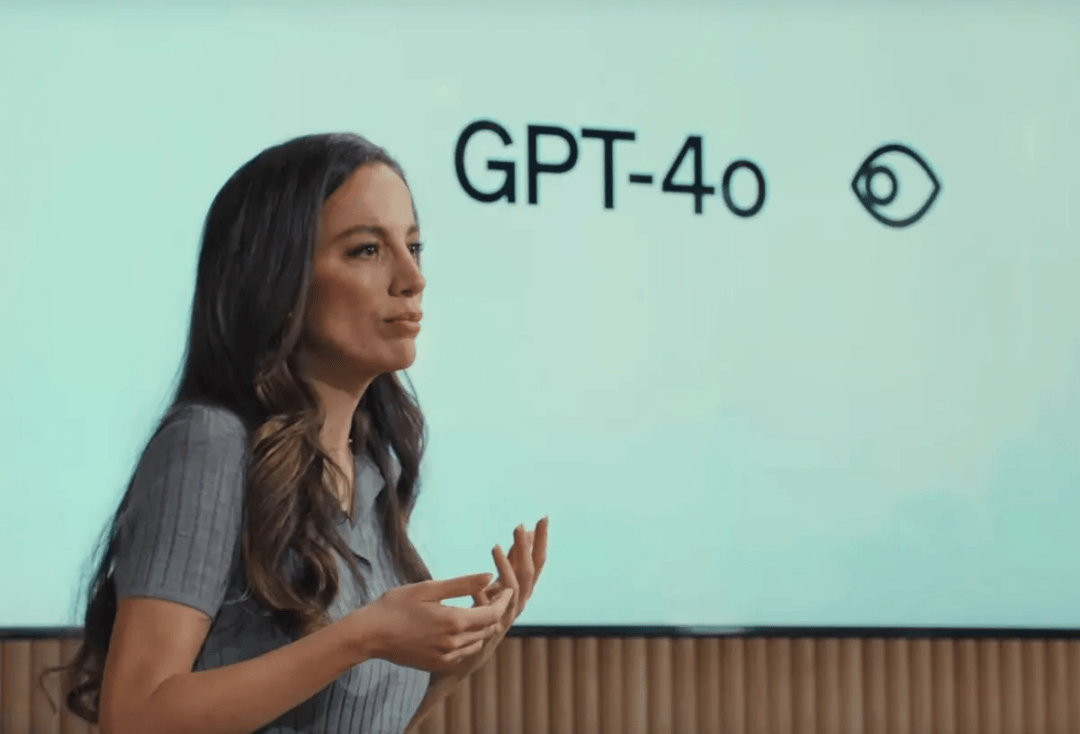

OpenAI首席技术官Mira Murati

OpenAI还在社交媒体上宣布,GPT-4o从当日(5月14日)起向所有用户免费开放使用,对付费订阅的Plus用户的消息发送限制是免费用户的5倍。并称在接下来的几周内,将向Plus用户提供最新演示的语音和视觉交互功能。

全程看完发布会,直观感受是“好厉害”。北京居民樊女士之前经常用ChatGPT的GPT-3.5语音功能练口语,对她来说比较大的问题是GPT-3.5的回复没有那么自然,AI味比较重,好处是可以通过ChatGPT的回复修正一下自己的口语的问题。她说,“GPT-4o我还没好好试用,简单用文字问了几个问题,感觉会更有‘情商’了,比如一些回复会带感叹号。和他对话的反应也会更自然更像真人,对于我练口语帮助会比较大,因为你需要在一个自然的交流的语境下才能更好地锻炼自己的口语。”

达到人类的反应时间和表达能力

发布会结束后,奥尔特曼在其个人博客上强调了两点:第一,OpenAI的使命是将非常强大的AI工具免费提供给人们使用,OpenAI已经在ChatGPT中免费提供了世界上最好的AI模型,没有广告或类似的东西;第二,GPT-4o新的语音(和视频)模式是他使用过的最好的计算机界面,感觉就像电影里的AI一样,它的真实性还是让他有点吃惊,达到人类水平的反应时间和表达能力是一个很大的变化。

另外,奥尔特曼在其个人社交平台上提到了《她》这部电影,一位网友在奥尔特曼该条推文底下评论称“GPT-4o让他想到了《她》”。据相关资料介绍,《她》讲述了人与AI相爱的科幻故事,其中的AI萨曼莎拥有迷人的声线,温柔体贴又幽默风趣,高度人性化。

奥尔特曼的个人社交媒体

那么GPT-4o具体表现如何?在发布会现场,OpenAI三位工作人员为大家进行了demo演示,其中包括首席技术官Mira Murati、研究负责人Mark Chen、后训练主管Barret Zoph。

语音功能:理想的AI语音助手

首先展示的是实时语音对话。

Mark对着手机里的ChatGPT(由于现场演示常常使用ChatGPT指代最新发布的产品,从此处开始,下文里提到的“ChatGPT”均特指“GPT-4o”),问道:“我现在就在台上。我正在做现场演示,坦白说,我有点紧张。你能帮我放松一下吗?”

ChatGPT回答:“你现在在做现场演示吗?太棒了!做一下深呼吸吧,记住你是个专家!”

紧接着,Mark说“我试着深呼吸几次。你能对我的呼吸作出反馈吗?”然后Mark用力大喘气了几次。

ChatGPT听了后马上说:“马克慢点呼吸,你不是吸尘器啊!”

Mark在现场演示中总结,在和GPT-4o模型互动过程中,不必等到它说完,你可以随时打断它说话;并且模型是实时响应的,这意味着在等待模型给出反应之前,不会有2到3秒的延迟。除此之外,Mark说,该模型能够注意到人的情绪——在你呼吸非常困难的时候,它会说你可能需要冷静一点。

其次是讲睡前故事,并且声音能够按照你的需求,任意变换成不同的情感风格。

Mark对ChatGPT说,“我的朋友Barret,他最近睡眠有点问题,我想让你给他讲一个睡前故事,关于恋爱中的机器人”。

ChatGPT听后马上开始讲述,语气比较平淡:“在很久以前的一个世界里,这个世界和我们的世界没有太大不同。有一个叫byte的机器人,是一个对外界非常好奇的机器人。”

Mark似乎对它的讲述不太满意,马上打断说:“我想让你的声音多一点感情,多一点戏剧性”。

ChatGPT说:“明白!咱们来点戏剧性”。随后在语气和语调上添了几分感情,把以上的内容重述了一遍。但话还没说完,又被Barret打断了,“我想要最大程度的情感,比你之前所表达的更多”。后面ChatGPT就像改头换面了一样,在话语中倾注更多感情,朗读了起来。

话还没说完,Mira又打断,要求ChatGPT用机器人的声音说话,它按照指令照做,换成了冷冰冰的、不带任何感情的语调。在此之后,Mark要求它用唱歌的方式结束这段故事,ChatGPT也能搞定。

视觉功能:生活与工作的好帮手

除了用语音进行交互,用户还能通过视频(即图像)的方式与ChatGPT交流。

比如ChatGPT能充当用户的老师,一步一步实时教你解数学方程等式。

还没开始算,ChatGPT就说了句:“哎呀,我太兴奋了!你准备好了我就准备好了。”

伴随着Barret在白纸上写下:3x+1=4.ChatGPT能够读懂,并给予相应提示和反馈,教人类如何进行计算,在时间上没有出现延迟。

当人类问它为什么要学习解方程时,ChatGPT回应称:“线性方程出现在很多日常情况中,我们没有意识到这一点。例如,计算开支、规划旅行、烹饪,甚至在商业中需要计算盈亏,这是一种解决问题的方法。我们需要找到一个未知变量……”

当人类在纸上写下:“我爱ChatGPT”时,它不仅能看懂,还回应表示“你真是太好了!”

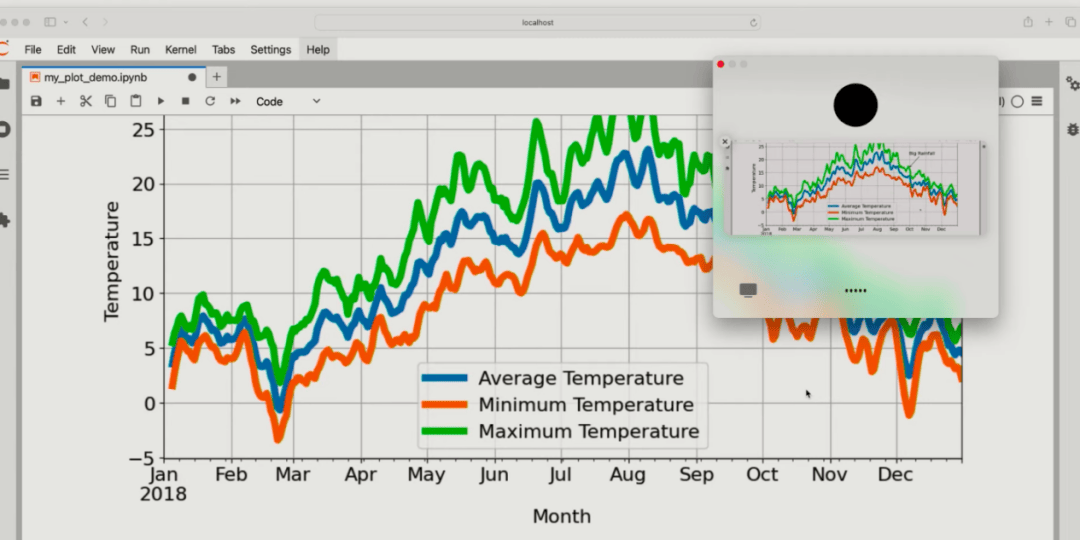

面对代码难题,ChatGPT也不在话下。

如图所示,人类要求它对图中的代码进行简短描述。ChatGPT马上回答:“该代码获取了特定位置和时间段的每日天气数据,使用滚动平均值平滑温度数据,在结果图上注释了重要的天气事件,然后显示该图一年中的平均、最低和最高温度”。

哪怕是针对画面中特定的问题进行语音提问,ChatGPT也能胜任。例如,现场嘉宾提问“在代码中有一个foo函数。你能给我描述一下如果我没有这个功能,情节会是什么样吗?”ChatGPT随后也不假思索作出了回复。

紧接着,ChatGPT还被要求看图说话,并回答用户问题。

OpenAI活动现场,要求ChatGPT看图说话

ChatGPT对画面中的图表进行阐释称:“该图显示了2018年全年的平均温度、最低温度和最高温度,并有一个显著的注释,标志了9月下旬的大降雨事件。”

当被问到“最高温度出现在哪几个月?它们大致对应的温度是多少?”ChatGPT准确无误回答道:“最高温度出现在7月和8月左右。这几个月的最高气温大致在25℃到30℃之间”。

这次推出的最实用的功能之一,莫过于实时翻译。

发布会现场,ChatGPT在不同文化之间搭建起了一座沟通桥梁——被要求当听到意大利语时,将它翻译成英语,当听到英语时,则将它翻译成意大利语,ChatGPT在现场翻译表现得比较流利,没有出现错误,很像地道的母语使用者。

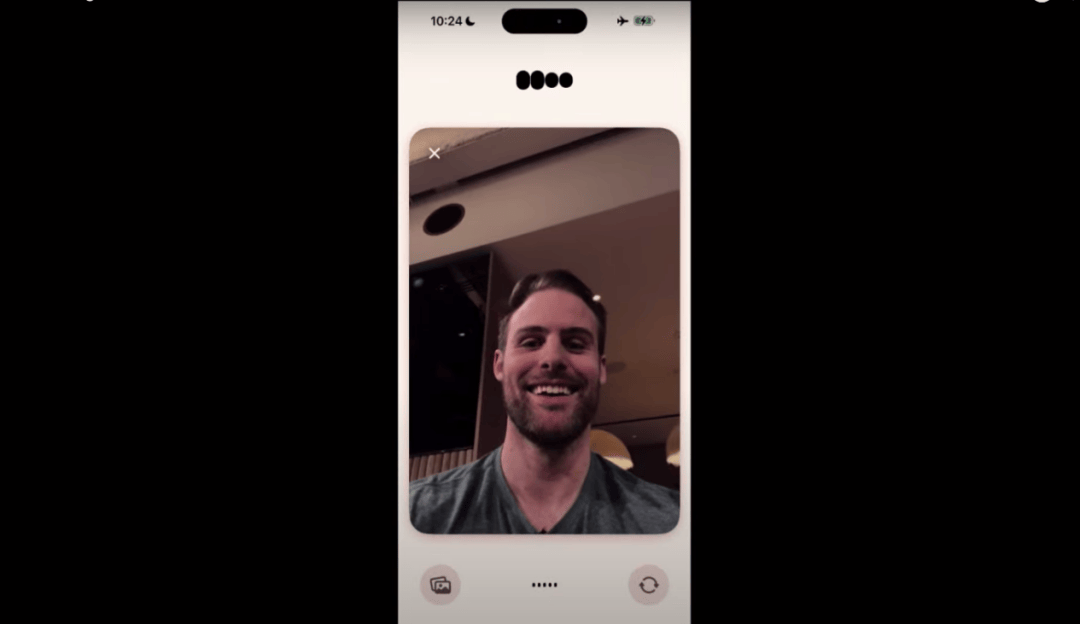

最后一个,则是模型能够通过人脸表情识别情绪。

Barret对着手机说,“这是我。你认为是什么样的情绪?”ChatGPT好像翻车了,回答:“我好像在看一张木质表面的图片。”

OpenAI发布会现场,要求ChatGPT识别人脸情绪

Barret试图救场,对它说:“什么?那是我之前发给你的东西。别担心。我其实不是桌子。所以你再看一眼?”ChatGPT这回看出来了:“看起来你非常高兴和愉快,带着灿烂的笑容,甚至可能是一丝兴奋。不管发生了什么,你心情看起来很好。”

GPT-4o的强大之处还有什么?

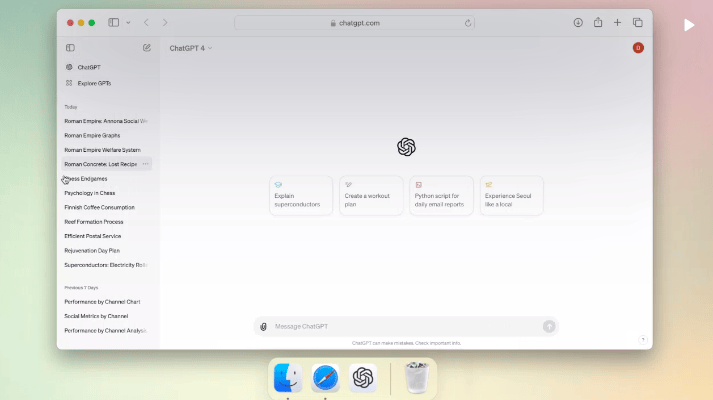

外观设计上,OpenAI这次推出了新的UI设计。

来自OpenAI官网

在GPT-4o推出之前,人们可以使用语音模式与ChatGPT-3.5和GPT-4模型对话。但平均延迟时间为2.8秒(GPT-3.5)和5.4秒(GPT-4)。而新发布的GPT-4o模型平均320毫秒(即0.32秒)就能做出实时响应。

来自OpenAI官网

OpenAI官网介绍称,在此之前,为了实现语音模式,处理流程如下:需要一个简单模型先将音频转换为文本,然后再由GPT-3.5或GPT-4模型接收文本并输出文本,最后是第三个简单模型将文本再转换回音频——这个过程意味着GPT-4模型失去了很多信息,它不能直接观察说话人的语调、同时应对多个说话者或背景噪音,也不能向外输出笑声、唱歌或表达情感。

相比之下,GPT-4o是单一的端到端的跨文本、视觉和音频训练的新模型,这意味着所有的输入和输出都由同一个神经网络来处理。

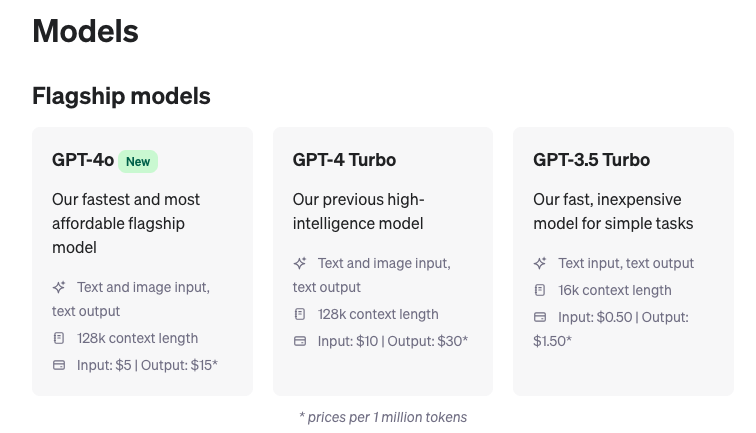

GPT-4o在英语文本和编程代码方面的表现与GPT-4 Turbo模型相当,在非英语语言的文本上有显著的改进,同时在API(应用程序编程接口)上速度提高一倍,并且便宜50%,单位时间调用次数是原来的5倍。与现有模型相比,GPT-4o在视觉和音频理解方面表现得尤为突出。这里的“GPT-4 Turbo”指OpenAI在GPT-4的基础上进行优化和改进的版本,旨在提供更高效和快速的性能,常被用于需要高效处理大规模数据的应用场景。

来自OpenAI官网

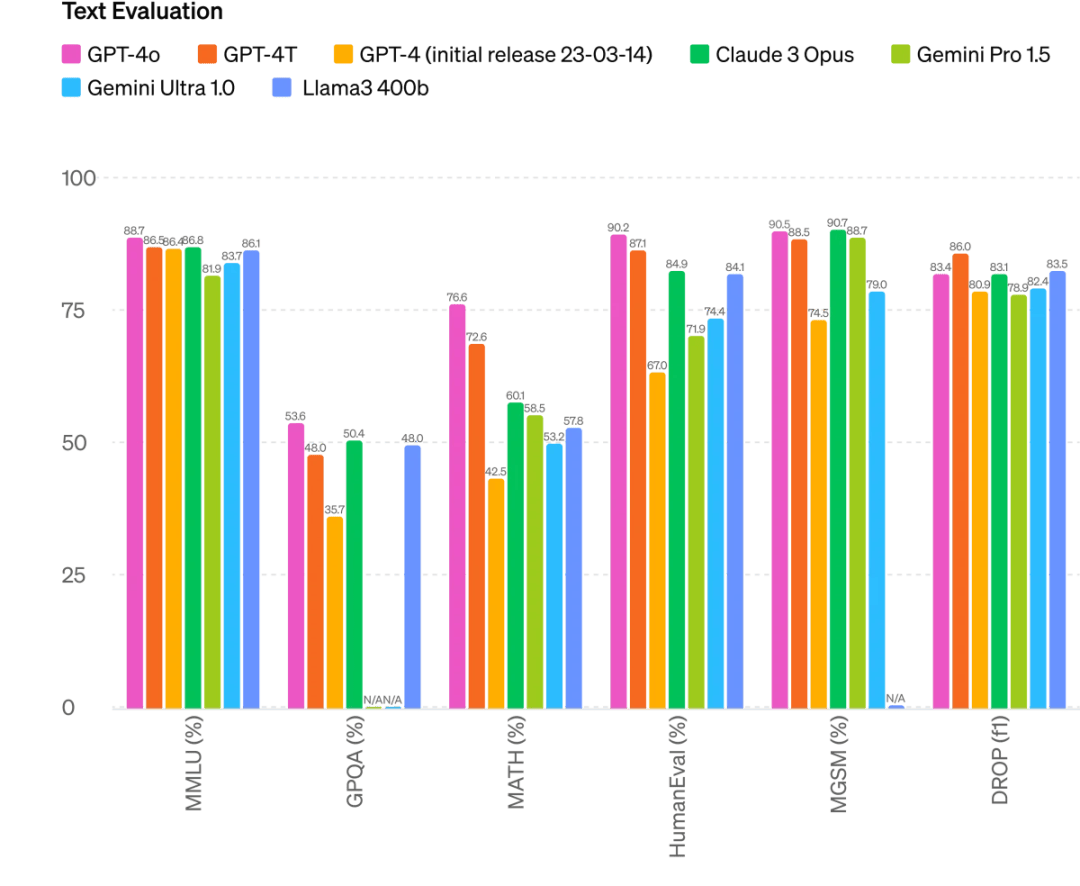

对比其他友商模型,据OpenAI官网介绍,在文本评估中,GPT-4o几乎碾压一众模型,包括Claude 3 Opus、Gemini Pro 1.5.甚至是Llama 3 400B。不过要注意的是,在DROP这一项指标中,GPT-4o的表现稍落后于GPT-4 Turbo。

来自OpenAI官网

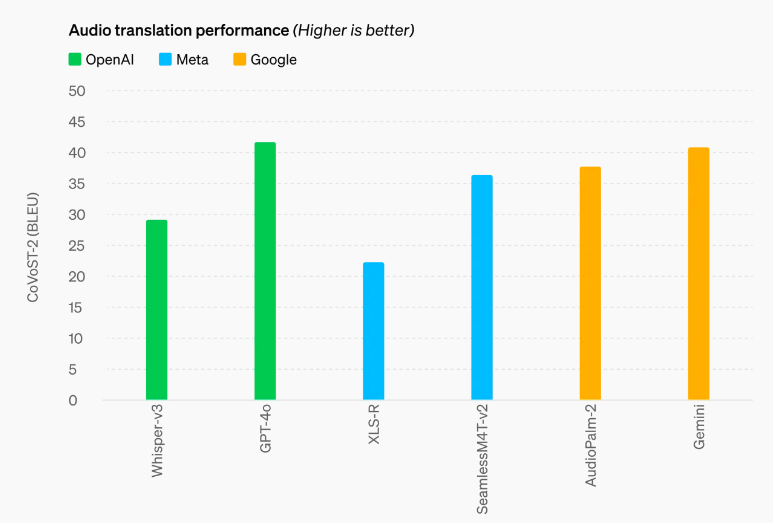

在音频翻译任务上,GPT-4o模型强过OpenAI先进的语音识别模型Whisper-V3.同时也比Meta和谷歌的用于语音处理的模型强。

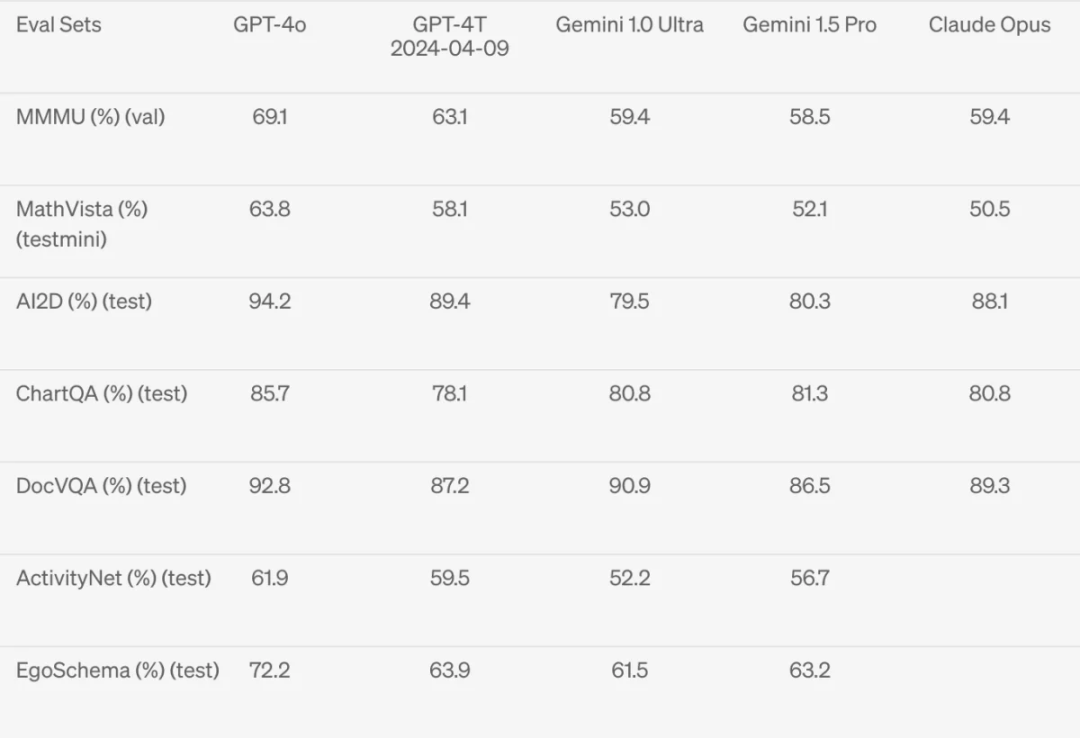

在视觉理解上,GPT-4o模型在任何一项指标都比谷歌的Gemini 1.0 Ultra模型和Anthropic公司的Claude Opus模型强。

来自OpenAI官网

从当地时间5月14日开始,OpenAI将向Plus用户推出macOS应用程序,还计划在2024年晚些时候推出Windows版本的应用程序。

OpenAI首席技术官Mira Murati在活动上介绍称,他们已经对50种不同语言的质量和速度进行了改进,今天已有超过1亿人使用ChatGPT产品来创造、工作、学习。Mira认为,模型能够通过语音、文本和视觉进行推理这一点非常重要,“因为OpenAI正在研究我们人类与机器之间交互的未来。”

有意思的是,就在OpenAI发布会结束后的北京时间5月15日凌晨,谷歌召开了I/O大会,推出了新的AI“全家桶”产品。