亚马逊披露多年自研芯片历程,与英伟达合作详情

为何“双管齐下”,一边与英伟达合作更加紧密,一边自研芯片?

·AWS正与英伟达合作推动Ceiba项目。英伟达将拥有自己的超级计算机供自己使用,并提供DGX云服务(训练即服务)给他们的最终客户,AWS也将为自己的客户提供英伟达GH200 NVL32的多节点集群。

·对于Trainium 2及Graviton 4在中国市场的推出时间,AWS计算和网络副总裁大卫•布朗在接受澎湃科技采访时表示还未有明确时间表。

在11月26日-12月1日期间举办的2023亚马逊云科技re:Invent全球大会上,亚马逊云科技(AWS)公布了其在硬件方面的诸多努力,推出了专为训练人工智能系统而设计的第二代芯片Trainium 2.以及通用Graviton 4处理器。英伟达CEO黄仁勋也到现场站台,宣布AWS成为第一家在云端配备英伟达最新GH200 Grace Hopper超级芯片的云厂商。

对于Trainium 2及Graviton 4在中国市场的推出时间,AWS计算和网络副总裁大卫•布朗(David Brown)在大会期间接受澎湃科技(www.thepaper.cn)采访时表示还未有明确时间表,“我不能100%确定时间。我们对所有实例的标准做法是,选择全球的几个地区首次推出,然后迅速查看其他可能推出的地区,这个过程基于客户需求和其他一些因素。在未来的几个月内,我们将更清楚何时进入中国市场。”

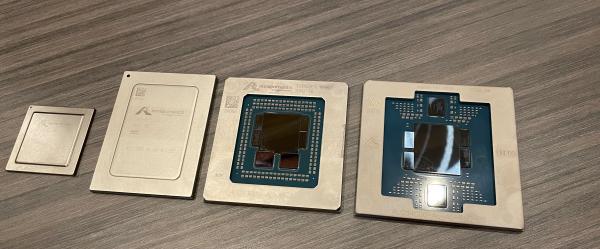

Amazon Graviton4 和Amazon Trainium(原型)。

在为期5天的会议期间,生成式人工智能几乎是每场论坛都会提及的高频词汇,成本优化则是相关热门话题。在此期间,记者对话亚马逊云科技数据库、数据分析和机器学习全球副总裁斯瓦米·西瓦苏布拉马尼安(Swami Sivasubramanian)和大卫•布朗,谈及与英伟达的合作详情,AWS自研芯片的发展过程,以及当下对生成式人工智能发展热潮的思考。

“成为运行英伟达GPU的最佳场所”

“我们与英伟达密切合作了很长时间,投入了大量资源,将最新的英伟达GPU引入AWS(亚马逊云科技)。”布朗表示,当你运行英伟达GPU时,要做得好非常具有挑战性。现在正在发生的事情是,这些GPU变得非常复杂,从工程角度来看,运行它们变得非常困难。“我认为AWS在如何运行这些GPU方面确实胜过其他所有竞争对手,我们也希望成为运行英伟达GPU的最佳场所。”

黄仁勋在大会现场的对话中提到了一个他称之为“惊人的”统计数据:仅在过去几年中,AWS在云中部署了200万个使用Ampere和Hopper架构的GPU,这相当于一个3000 EFLOPS(每秒进行百亿亿次浮点运算)运算性能的超级计算机。

“拥有一台百亿亿级次浮点运算性能的超级计算机就非常令人羡慕,而AWS相当于拥有3000台这样的超级计算机。”黄仁勋说,“这才只是一个开始。我们与AWS的合作仍在以惊人的速度增长。每个季度,我们都会为AWS部署超过1 ZFLOPS(1 ZFLOPS=1000 EFLOPS)的计算能力,这是一个令人难以置信的数字,我们两个团队建立了一整套新的基础设施。”

与此同时,AWS实际上一直在投资自己的定制芯片,从2013年推出首颗Nitro 1芯片至今,AWS是最先涉足自研芯片的云厂商,已拥有虚拟化芯片、服务器芯片、人工智能机器学习自研芯片3条产品线。

为何“双管齐下”,一边与英伟达合作更加紧密,一边自研芯片?

布朗解释称,一切都是为了确保客户有选择。“选择是如此重要。它真的推动了正向的客户体验,并且从长远来看,这将带来最好的结果,因为所有这些选择都在独立创新,彼此竞争。在某些情况下,一些工作负载可能在Trainium上,而在其他情况下可能在英伟达上,所以最终可能不会有一个赢家,始终会有英伟达、Trainium和市场上的其他选择。”

对于为何AWS有自研的Titan大模型,同时又投资OpenAI的竞争对手Anthropic,在AWS平台同时提供Claude 2大模型等选项,西瓦苏布拉马尼安也给了相似的答案。“它们实际上具有不同的能力,Claude 2具有非常好的推理能力,而Titan模型非常灵活,两者在性能成本等方面也很不同。我认为拥有更多的选择从客户角度来看是一件好事,这也是激励我们的原因。”

AWS正与英伟达合作推动Ceiba项目,计划构建全球最快的GPU驱动的AI超级计算机——配置16384颗英伟达H200超级芯片,能处理65 EFLOPS速度等级的AI运算,为英伟达研发团队提供服务。

对于记者询问Ceiba项目是否只服务于英伟达,布朗表示,英伟达将拥有自己的超级计算机供自己使用,并提供DGX云服务(训练即服务,AI-training-as-a-service)给他们的最终客户,AWS也将为自己的客户提供英伟达GH200 NVL32的多节点集群。

“继续成本优化”

“我在这周进行的对话实际上都关于如何继续成本优化。生成式人工智能如此新颖,大家都在努力弄清楚如何在业务中应用它,但有两件事必须考虑清楚。”布朗说。

第一是构建概念验证,真正测试生成式人工智能对业务的潜在影响。第二,当企业拥有了生成式人工智能解决方案,必须确保它可以适应企业的损益表。如果运行成本过高,实际上无法部署,因为它将没有用处。布朗表示,“无论是通过开发模型还是Trainium芯片这样的方式,我们都希望真正降低生成式人工智能所需的成本。”

西瓦苏布拉马尼安也在对话中表示,企业需要的不仅仅是更大的模型,更关键的是投资回报。“比如我正在构建生成式人工智能应用程序,希望增加收入或降低成本,但我不想在推理上花费巨额资金,因为这意味着我可能无法产生盈利。当我们与这些企业合作时,他们会意识到其实际上需要的是一个较小的模型以适应特定用例,这样就可以在不使用大型模型的情况下从生成式人工智能中获得价值。他们实际上从一个非常庞大的模型过渡到了经过精细调整的较小模型,并取得了更低的成本、更高的准确性和更好的性能。”

在回顾AWS从2013年推出Nitro芯片的历程时,被高频提及的也是成本优化。“摩尔定律(注:摩尔定律指集成电路上可容纳的晶体管数目,约每隔18-24个月便会增加一倍,性能也将提升一倍。)早在十几年前就有所减弱,就像人们说的,我们不可能让这些芯片再快一点了,因为如果再添加更多的晶体管,就无法保持冷却效果,这是一个物理问题。我们正处于这样一个旅程中,我们需要思考,如何持续提高性能、降低成本?”布朗表示,“除非我们真的涉足芯片并在硬件上进行创新,否则我们所能做的事情就会受到限制,我们不能仅仅依赖于行业中现有的东西。因此,我们首先从Nitro开始这个旅程。”

布朗继续分享道,“然后我们想,是否真的可以构建一款服务器芯片?这个想法是,我们可以构建一款基于Arm架构的芯片。Arm架构就在每个人的手机上,它的功耗很低,因为其整个芯片的架构都是为全天电池运行而设计,它还有一个强大的生态系统,有很多为手机编写的应用程序。我们当时认为Arm架构是我们构建服务器芯片的完美选择,这就是Graviton的由来。”

推理芯片Inferentia和训练芯片Trainium则可以追溯到5年前,当时布朗团队认为,机器学习中的绝大部分成本实际上是推理,如果能够构建一个推理芯片并降低推理成本,客户就可以完成更多推理并改进应用程序,训练方面也同样。“现在由于生成式人工智能的原因,训练占主导地位,但随着更多人使用生成式人工智能,推理的工作负载会在时间的推移中恢复,Inferentia 2将非常适合这个用途。”布朗说。

目前这些工作已经带来了回报,据布朗介绍,Graviton比当时的可用产品计算性能提升了40%,Graviton 2比前一代提高了25%,Graviton 3比Graviton 2更优,现在Graviton 4至少比Graviton 3提高了30%。

从左至右依次为Graviton 1、Graviton 2、Graviton 3、Graviton 4.图片来源:澎湃科技

“这就是我们在Graviton上看到的,我们正在改变芯片的架构方式,改变简化芯片的方式,改变为芯片提供电源的方式,同时还有许多可以提高性能的方法。因此,摩尔定律的消失并不意味着我们不再能通过创新和加速性能的方式来发展。”布朗说。

解决算力需求剧增带来的环境问题

对于2024年生成式人工智能如何发展有何判断?西瓦苏布拉马尼安对澎湃科技表示,这些模型将因其推理能力等的不断提升而变得越来越强大,因此我们将会看到更多的应用。

而随着生成式人工智能应用到各个领域,对算力的需求也会进一步剧增,如何解决高算力带来的能源消耗与环保问题?

据布朗透露,到2040年,亚马逊公司整体将实现碳中和,但这包括货车、飞机等,因此,在碳足迹方面,AWS将在2030年实现碳中和。

“这意味着我们在数据中心使用的电力将来自绿色能源,如风、水、太阳能,或者如果我们必须消耗不来自绿色能源的电力,我们将购买碳抵消来确保该电力从碳中和的角度来看是绿色的。我们正在按计划实现2030年的碳中和目标,到2025年,我们实际上产生的清洁水将比消耗的更多。”布朗说。

那么在芯片方面如何更加节能?布朗说,“最好的办法就是不使用电力。因此,使用Graviton会比同类芯片少用60%的电来完成相同的工作负载,这意味着在我们工作负载上所用的能量要比在其他云服务提供商上看到的要少得多。如果看Trainium 2.它实际上使用的能量比Trainium 1完成相同工作负载要少两倍。”

布朗透露,英伟达也在关注这个问题,“我们也一直在与英特尔、AMD等交流,讨论他们使用的功率?尽管对算力的需求正在以疯狂的速度增长,但我们确实需要一个更加节能的世界,这是有限的资源。”